Notre site dispose désormais d'un mode éco. N'hésitez pas à l'essayer !

L'A/B testing, également connu sous le nom de split testing, est une technique de test pour comparer les performances de deux versions d'un élément de marketing, comme une page de destination, une publicité ou un email marketing.

Le but de l'A/B testing est de déterminer laquelle des deux versions est la plus performante en termes de taux de conversion, de taux de clics ou d'autres indicateurs clé de performance. L’intérêt est de prendre des décisions basées sur des données objectives plutôt que sur des conjectures, ou des suppositions, en plus d’améliorer les performances de vos campagnes marketing et maximiser le retour sur investissement de vos efforts. Enfin, cela peut également vous aider à comprendre les préférences et les comportements de vos utilisateurs, ce qui peut être utile pour améliorer les produits et les services que vous offrez.

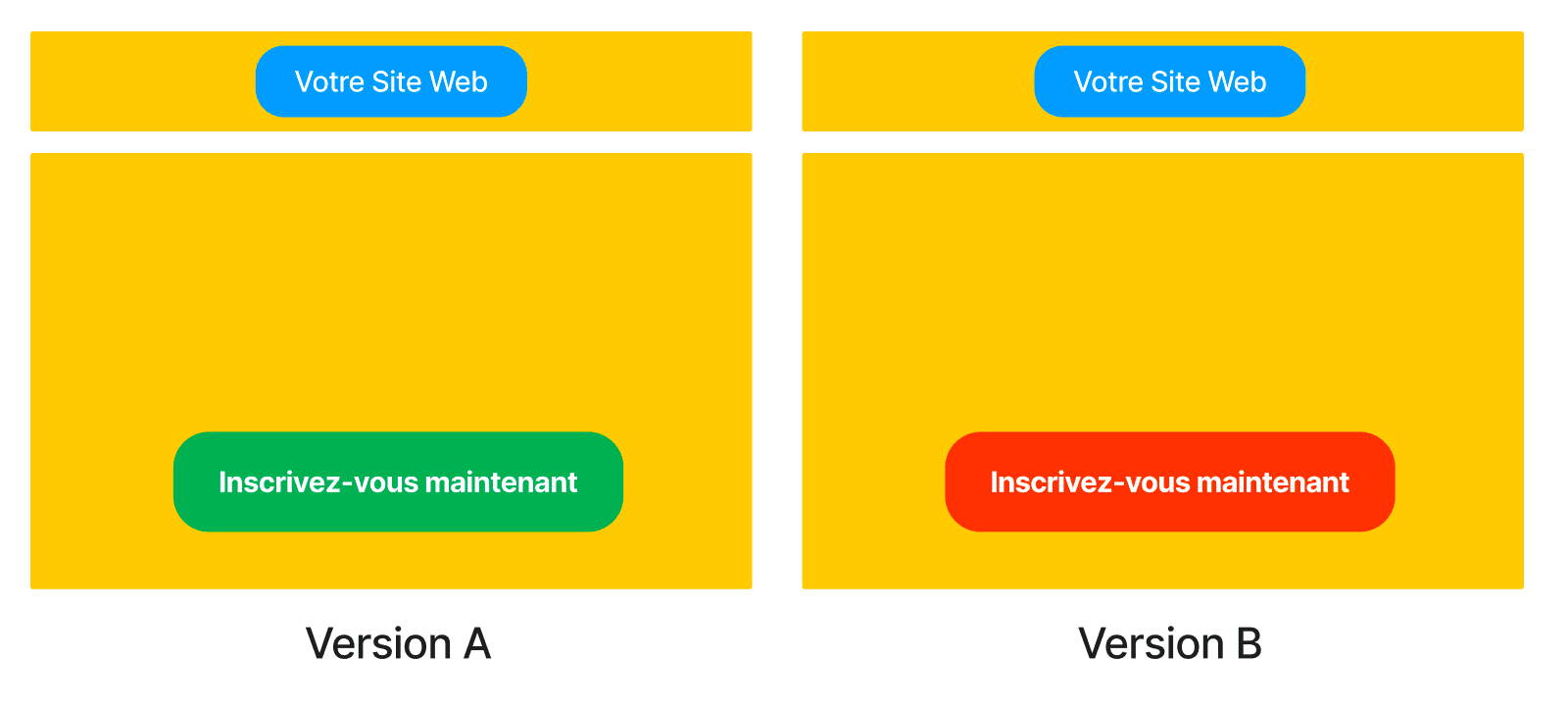

Pour mettre en place un A/B test, vous devez d'abord créer deux versions de l'élément marketing que vous souhaitez tester. Par exemple, si vous souhaiter tester une page de destination, vous devrez créer deux versions différentes de cette page, en modifiant un ou plusieurs éléments tels que le titre, les images, le texte ou les appels à l'action.

Une fois que les deux versions sont prêtes, vous pouvez les mettre en ligne et commencer le test en dirigeant un échantillon représentatif de votre audience vers chacune des versions. Pendant le test, vous pouvez suivre les performances des deux versions en utilisant des outils d'analyse et de suivi pour mesurer des indicateurs tels que le taux de conversion, le taux de clics ou le temps passé sur la page…

Il existe plusieurs approches pour mettre en place un test, notamment le redirect testing, l’A/B testing et le multivariate testing. Le choix de l'approche dépend de la situation et des objectifs du test, ainsi que des ressources et des compétences disponibles.

Pour terminer cette première partie voici une représentation “simple” et visuelle d’un A/B test envisageable sur votre site.

Voici quelques avantages que vous pouvez tirer de l'A/B testing :

Le choix de l'approche dépend de la situation et des objectifs du test, ainsi que des ressources et des compétences disponibles. Il est important de choisir l'approche qui convient le mieux à chaque situation pour obtenir les meilleurs résultats possibles.

Un biais est tout facteur qui peut influencer le comportement de l'échantillon de population étudié. Il peut s'agir de différences dans les sources de trafic, les appareils, l'heure de la journée, les caractéristiques socio-démographiques, et tout autre élément qui entraîne un manque d'uniformité dans la population qui verra différentes versions d'une page. Les biais peuvent avoir un impact significatif sur les résultats d'une étude ou d'une expérience, et il est important de les prendre en compte afin d'obtenir des résultats précis et fiables.

De nombreux biais peuvent affecter les résultats d'une étude ou d'une expérience, notamment la représentativité de la population de l'échantillon. Par exemple, si vous présentez une version différente d'une page aux utilisateurs de téléphones mobiles et aux utilisateurs d'ordinateurs de bureau, vous pouvez agir en fonction d'hypothèses sur les caractéristiques de chaque groupe. Cependant, cela peut être problématique car cela ignore l'impact que le contexte d'un utilisateur peut avoir sur son comportement. Par exemple, une personne ne fera peut-être pas les mêmes achats sur son ordinateur personnel que sur son téléphone dans les transports en commun.

Mais le biais le plus important et potentiellement dangereux ne concerne pas la population observée, mais l'observateur lui-même. Nous nous sommes tous retrouvés à travailler sur une page d'accueil en pensant qu'elle allait être un succès, pour finalement la lancer et ne voir que peu ou pas d'engagement. Cela peut être frustrant, mais c'est aussi un rappel que le véritable problème de la représentativité dans les tests est le risque de partialité de la part de l'observateur. Il est important de rester objectif et d'éviter de faire des suppositions sur le succès d'une page ou d'une expérience en fonction de nos croyances personnelles ou de nos préjugés.

Il est important de tenir compte des biais contextuels lors de la réalisation d'expériences ou de l'analyse de données. Cependant, il peut être encore pire de s'appuyer sur des statistiques trop faibles pour tirer des conclusions significatives. C'est là que le concept de signification statistique entre en jeu.

En statistique, le résultat d'une étude portant sur un échantillon de population est considéré comme statistiquement significatif lorsqu'il est peu probable qu'il soit dû à des facteurs tels qu'un échantillon incorrect ou non représentatif (inférence bayésienne). Cette fiabilité est généralement déterminée en examinant les valeurs, les différences de valeurs ou les relations entre les valeurs, et en déterminant si elles sont suffisamment élevées ou faibles pour être considérées comme significatives. En “général”, on attend d'atteindre une fiabilité de 95% avant de prendre une décision. Nous interpréterons ces 95% comme le fait qu'il y a 95% de chances que la version A soit effectivement plus efficace que la version B dans notre test.

Il existe de nombreux outils pour faire de l’A/B testing, certains sont payants (avec une période d’essai gratuit, cela dépend), comme Optimizely, VWO, A/B Tasty… et pleins d’autres. (veillez à vérifier le volume entrant sur votre site car les tarifs grimpent vite et il est parfois difficile de justifier ce genre d’outil/test, lorsque le volume n’est pas suffisant, ce qui est souvent le cas dans des pays a faible volume comme le Luxembourg.)

Vous en savez désormais un peu plus sur l’A/B testing et les différentes possibilités, il ne vous reste plus qu’à implémenter ça dans votre stratégie.